Open-Source LLMs: Gamechanger oder Hype? Alles, was du wissen musst!

Warum Open-Source KI die Business-Welt verändert

Künstliche Intelligenz ist längst kein Luxus mehr – sie ist ein entscheidender Wettbewerbsfaktor. Doch viele Unternehmen scheuen sich vor der Nutzung, weil Datenschutz, Kosten oder Abhängigkeit von großen Anbietern wie OpenAI oder Google eine Rolle spielen. Die Lösung? Open-Source LLMs!

Mit frei zugänglichen Sprachmodellen können Unternehmen eigene KI-Lösungen entwickeln, anpassen und unabhängig betreiben. Doch welche Modelle lohnen sich? Welche Hardware ist nötig? Und wie können Unternehmen konkret davon profitieren?

Was sind Open-Source LLMs?

Open-Source LLMs sind frei verfügbare, quelloffene KI-Sprachmodelle. Das bedeutet, dass ihr Architektur-Code und ihre sogenannten Modellgewichte öffentlich zugänglich sind. Allerdings sind nicht immer alle Trainingsdaten und Prozesse offengelegt. Neben Sprachmodellen gibt es auch Open-Source-Modelle für Bildgenerierung, Audioverarbeitung und mehr.

Vorteile von Open-Source LLMs gegenüber Closed-Source?

✅ Datenschutz & Kontrolle – Besonders für Unternehmen, die sensible Daten verarbeiten, sind Open-Source-Modelle interessant. DSGVO-konforme Lösungen lassen sich einfacher realisieren.

✅ Kosteneffizienz – Keine Lizenzgebühren, nur Infrastrukturkosten.

✅ Anpassbarkeit – Modelle können trainiert und optimiert werden, um spezifische Business-Bedürfnisse zu erfüllen.

✅ Offline-Nutzung – Ideal für Anwendungen, die ohne Internetanbindung laufen sollen.

Die leistungsstärksten Open-Source LLMs im Überblick

Der Open-Source-Markt wächst rasant. Aktuell gehören diese Modelle zu den leistungsfähigsten:

🔹 Meta Llama 3 (1B - 405B Parameter) – Sehr leistungsfähig, aber mit eingeschränkter Lizenz.

🔹 Google Gemma 2 (2B - 27B Parameter) – Entwickelt für vielseitige Anwendungen.

🔹 Mistral & Mixtral (7B - 123B Parameter) – Starke europäische Alternativen mit hoher Performance.

🔹 Deepseek R1 & V3 (1.5B - 671B Parameter) – Modelle mit beachtlicher Skalierbarkeit.

⚠ Vorsicht: Nicht alle Open-Source-Modelle sind vollständig frei einsetzbar!

Llama 3 und Mistral haben bestimmte Lizenzbeschränkungen, die vor dem Einsatz überprüft werden müssen.

Welche Hardware wird für Open-Source LLMs benötigt?

Ein großer Vorteil von Open-Source LLMs ist, dass sie auch ohne riesige Rechenzentren betrieben werden können – zumindest in kleinerer Form.

💻 Kleine Modelle (bis ~8B Parameter) – Laufen oft noch auf modernen CPUs, ohne dedizierte GPU.

🚀 Größere Modelle – Benötigen GPUs mit ausreichend VRAM für schnelle Verarbeitung.

🔧 Beispiel: MacBook Pro M3 Pro (18GB RAM) – Kann Deepseek R1 14B betreiben, aber nur mit begrenzter Geschwindigkeit.

📈 Für Enterprise-Nutzung – Spezielle High-End-GPUs sind erforderlich, mehr dazu hier.

Wo finde ich Open-Source LLMs?

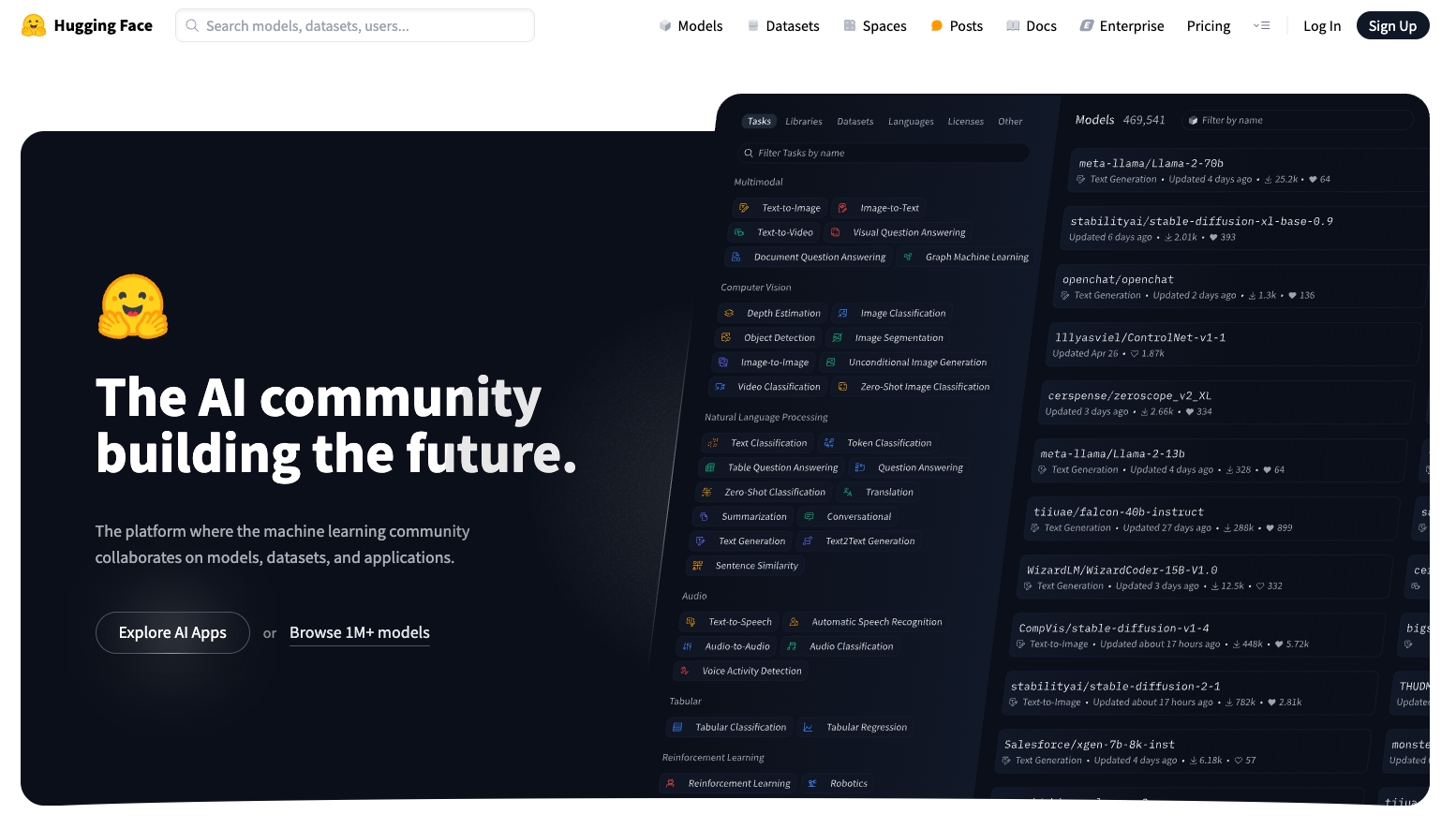

Die wichtigsten Plattformen für Open-Source LLMs:

🌐 Huggingface – Der zentrale Hub für Open-Source-Modelle.

🌐 Ollama – Einfacher Zugang zu Open-Source-KI.

🌐 Open WebUI – Nützliches Web-Interface für LLMs.

Tipp: Wer Performance-Vergleiche der Modelle sehen möchte, findet auf Artificial Analysis aktuelle Bewertungen.

Wie Unternehmen Open-Source LLMs nutzen können

🚀 KI-gestützte Chatbots – Intern oder für Kundenservice, ohne Cloud-Abhängigkeit.

🔒 DSGVO-konforme Datenverarbeitung – Schutz sensibler Informationen durch On-Premise-Lösungen.

📊 Automatische Textanalyse & Daten-Klassifikation – Effizient und kostengünstig mit kleineren Modellen.

💡 Offline-KI-Anwendungen – Besonders nützlich in sicherheitskritischen Umgebungen.

Lohnt sich Open-Source KI für Ihr Unternehmen?

Unternehmen, die Kontrolle, Datenschutz und Kosteneffizienz in den Vordergrund stellen, sollten Open-Source LLMs in Betracht ziehen. Die Technologie entwickelt sich rasant – jetzt ist der richtige Zeitpunkt, um KI unabhängig und maßgeschneidert einzusetzen.

Fazit: Selbst-Hosting als Zukunftschance

Open-Source-LLMs bieten Unternehmen eine überzeugende Alternative zu proprietären KI-Diensten. Sie ermöglichen datenschutzkonforme Lösungen, bieten Unabhängigkeit und sind flexibel anpassbar. Während kleinere Modelle bereits gut lokal betrieben werden können, bleibt der Einsatz großer LLMs technisch anspruchsvoll. Allerdings bringen kleine Modelle den Nachteil mit sich, nicht die Leistungsfähigkeit großer Systeme zu erreichen. Ein hybrider Ansatz kann daher sinnvoll sein: Ein vorgeschaltetes, lokal betriebenes Modell bereitet die Daten auf und leitet sie anschließend an ein leistungsstärkeres Modell weiter.

Sind Open-Source-LLMs eine Lösung für Ihr Unternehmen? Lassen Sie uns gemeinsam Ihre Strategie entwickeln.